花了点时间写了个股票分析软件,有的功能达到了预期效果,有的没达到效果。用ai编程写的,效率比我自己写高不少,感觉快个三四倍。

主要用的技术栈:

数据采集主要用的python+akshare,数据存储使用的clickhouse。主要抓取了十五年的日k线和行业数据。大概5400个股票数据,我只关注60和00的股票,不到3200家。

展示端做的桌面软件,使用c++,界面还是用的imgui,画线用的implot。直接读clickhouse数据库拿数据。本来想做成web的,想了想没啥必要,我也不会部署到服务器,而且还得多写个后端服务。数据大概1个G左右,我没有定制压缩和编码算法,使用的默认的。因为我之前参加过压缩算法的比赛,想了想这个东西还是得测,想当然没啥用。不是特别关注的点,所以懒得搞了。

功能上:

实现了k线图,均线(ai自动实现的),macd。k线图刚开始犹豫要不要加,后来想想,我过滤算法过滤出来,总不能再在别的软件上一个一个找,然后再分析,所以还是加上这个功能了。

macd自己搞的过滤算法,筛选股票,但是结果不尽人意,我还得接着改算法。

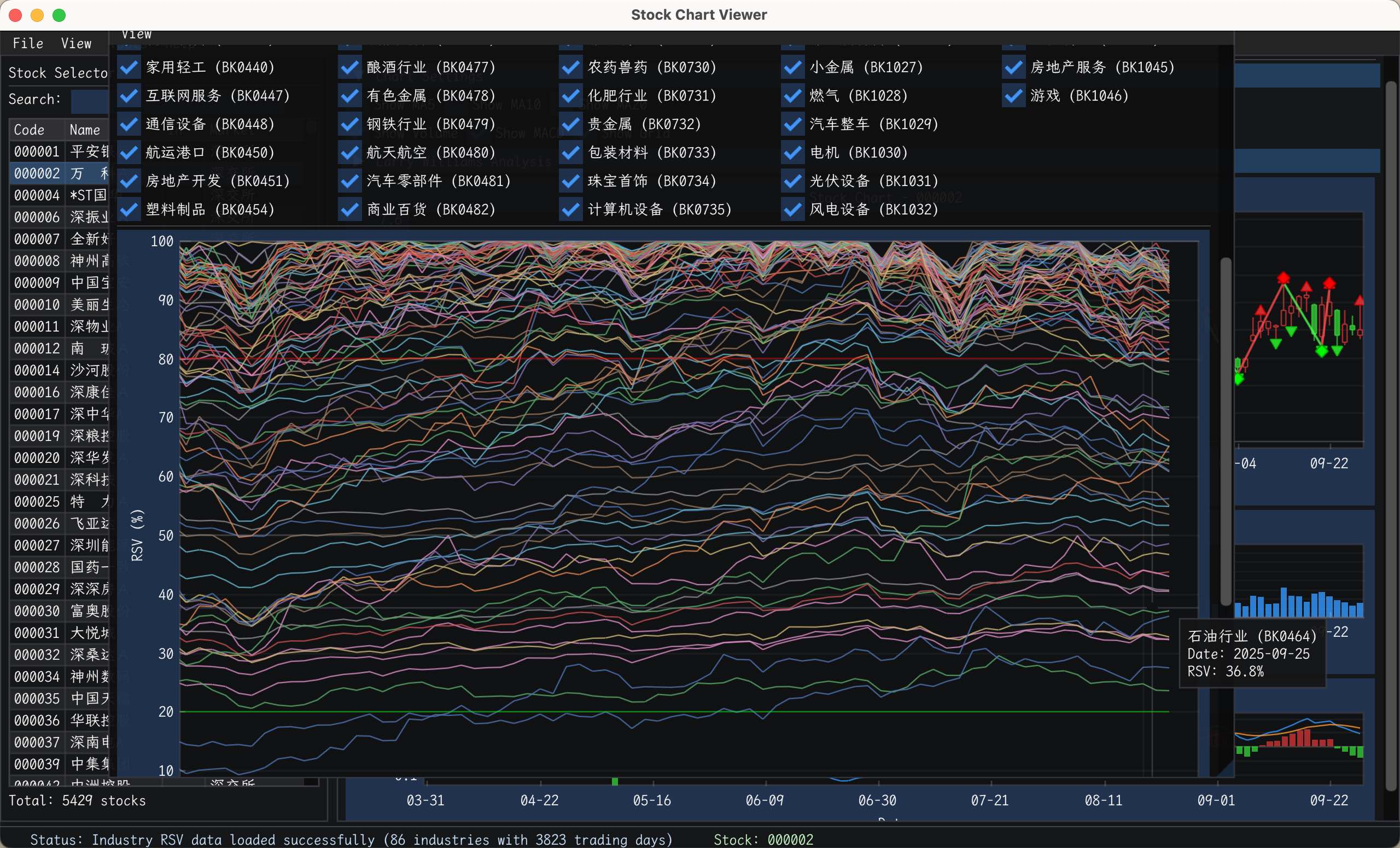

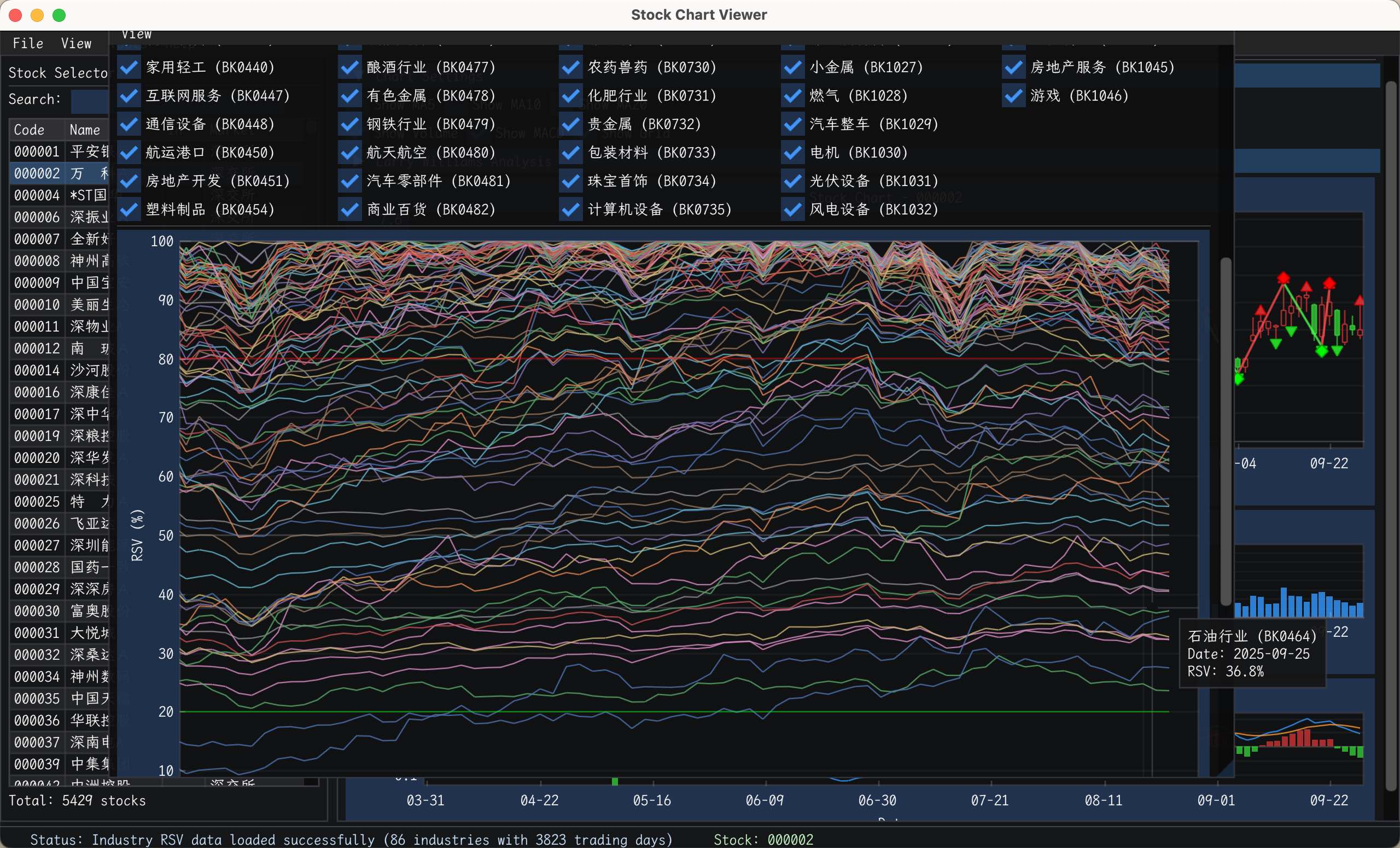

行业对比图,直观看那些行业属于启动了,或者历史顶部底部。这个功能比较满意.

实现的买卖点趋势图。买卖点我还没标注,主要看k线画趋势麻烦,有趋势了,买卖点一眼就看到了。这个功能比较好用,很满意。

想着实现的功能:

本来还想搞搞历史回测功能,写过滤算法或者交易算法,不回测直接上资金也不太行。算法优化暂时不搞了,这个后面再加吧。

界面:

Read more...